Eξ αιτίας ενός βίντεο, το οποίο ανέβηκε παραμονή πρωτοχρονιάς στην μεγαλύτερη βίντεο πλατφόρμα του πλανήτη και κυριολεκτικά γελοιοποίησε το γεγονός του θανάτου ενός αυτόχειρα (εντάσσοντάς το στην ηλίθια φλυαρία ενός δημοφιλή δημιουργού της πλατφόρμας), το YouTube αποφάσισε να λάβει δρακόντεια μέτρα για να εμποδίζει στο εξής οποιοδήποτε «ανάρμοστο» περιεχόμενο ανεβαίνει στα κανάλια του. Μέτρα που αρχικά επηρεάζουν πολλές χιλιάδες, λιγότερους γνωστούς, δημιουργούς οι οποίοι πλέον δεν μπορούν να χρησιμοποιήσουν οποιοδήποτε πρόγραμμα κέρδους από τις επισκέψεις των οπαδών στα κανάλια τους.

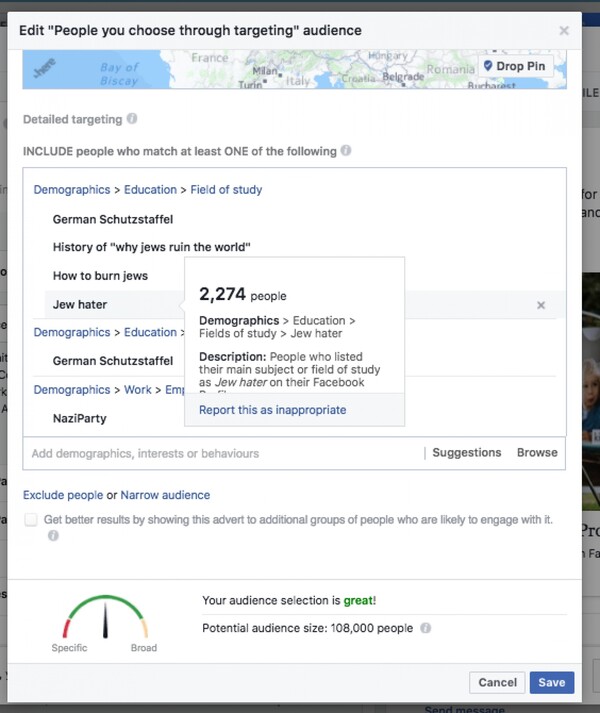

Μια άλλη στοχευμένη διαφήμιση, πριν λίγους μήνες, απέδειξε ότι μέσα στο Facebook μπορούσε κάποιος να «κατευθύνει» το προϊόν του σε ομάδες που μισούν τους Εβραίους ή σε ομάδες Ναζί. Με άλλα λόγια, τα κοινωνικά δίκτυα, μέχρι πριν λίγο καιρό, μαστίζονταν από ακατάλληλο υλικό που κατάφερνε να γλιστρήσει μέσα από τις ρωγμές τους.

Μέχρι σήμερα, το μεγάλο όπλο όλων των τεχνολογικών κολοσσών ήταν και συνεχίζει να είναι η Τεχνητή Νοημοσύνη, αλλά όπως φαίνεται η μηχανική μάθηση δεν είναι ακόμα ικανή να μάθει στις μηχανές πώς να πιάνουν "πουλιά στον αέρα". Έτσι, ενώ όλα τα κοινωνικά δίκτυα θέλουν να την εμπιστεύονται, εκείνη αποτυγχάνει οικτρά. Το μεγάλο της πρόβλημα είναι ότι ενώ μπορεί να «επισημαίνει» γρήγορα την προσβλητική γλώσσα ή ενώ μπορεί να αναγνωρίζει τις εικόνες πολύ καλά, δεν ξέρει ακόμα τι σημαίνει «πρόθεση».

Χρησιμοποιώντας την επεξεργασία της φυσικής γλώσσας, η ΤΝ μπορεί να εκπαιδευθεί ώστε να αναγνωρίζει το κείμενο σε πολλές γλώσσες. Έτσι ένα πρόγραμμα που έχει σχεδιαστεί για να εντοπίζει τις παραβιάσεις των οδηγιών μιας κοινότητας, για παράδειγμα, μπορεί με τον ίδιο τρόπο να ανιχνεύει υβριστικές λέξεις που σχετίζονται με φυλετικές διακρίσεις ή εξτρεμιστική προπαγάνδα.

Η Τεχνητή Νοημοσύνη μπορεί επίσης να εκπαιδευθεί ώστε να αναγνωρίζει εικόνες, ή να αποτρέπει το γυμνό και άλλα σύμβολα, όπως μια σβάστικα. Λειτουργεί καλά, σε πολλές περιπτώσεις, αλλά δεν είναι ένα «ξέγνοιαστο» σύστημα. Το 2015 η Google Photos κατηγορήθηκε για την προσθήκη ετικετών σε εικόνες με έγχρωμους ανθρώπους με τη λέξη «γορίλας». Τρία χρόνια αργότερα, η Google ακόμη δεν έχει βρει λύση για το πρόβλημα, οπότε αποφάσισε κάποια στιγμή να καταργήσει εντελώς τα tags του προγράμματος σε πιθήκους και γορίλες. Οι χρήστες της LGBTQ κοινότητας του Twitter πρόσφατα είχαν ανακαλύψει την έλλειψη αποτελεσμάτων για #gay και #bisexual αναζητήσεων και το κοινωνικό δίκτυο ζήτησε συγνώμη γαι το σφάλμα, ρίχνοντας όλο το φταίξιμο σε έναν παρωχημένο αλγόριθμο.

Google Photos, y'all fucked up. My friend's not a gorilla. pic.twitter.com/SMkMCsNVX4

— BoycottTheNFL (@jackyalcine) June 29, 2015

H αλήθεια είναι ότι στις μέρες μας η ΤΝ δεν μπορεί να κάνει τίποτα παραπάνω από το να μεροληπτεί. Η αποτυχία της προσθήκης ετικετών «γορίλας» σε εικόνες ζώων δείχνει ξεκάθαρα πόσο προκατειλημμένη είναι ακόμη αυτή η τεχνολογία. Και έαν αναρωτιώμαστε πώς είναι δυνατόν ένα κομπιούτερ να είναι προκατειλημένο, θα πρέπει να καταλάβουμε ότι κάθε τεχνητή νοημοσύνη (η οποία ζει μέσα σε έναν δυνατό υπολογιστή) εκπαιδεύεται από ανθρώπους που δουλεύουν με πλήρη καθήκοντα, εισάγοντας τα αποτελέσματα των εργασιών τους στο σύστημά της. Για παράδειγμα, τα προγράμματα που χρησιμοποιούνται για να αναγνωρίζουν αντικείμενα ή σύμβολα σε μια φωτογραφία, έχουν πρώτα χορτάσει από χιλιάδες εικόνες που τα τάισαν ανθρώπινα χέρια.

Το ανθρώπινο στοιχείο είναι εκείνο που καθιστά δυνατή την ΤΝ να ολοκληρώσει καθήκοντα που θα ήταν αδύνατα προηγουμένως για ένα τυπικό λογισμικό, αλλά το ίδιο ανθρώπινο στοιχείο είναι κι αυτό που μπορεί να δώσει επίσης και μια λάθος ανθρώπινη προκατάληψη σε έναν υπολογιστή. Γιατί ένα πρόγραμμα ΤΝ είναι τόσο καλό όσο και τα δεδομένα που το τάισαν - αν για παράδειγμα ένα σύστημα τροφοδοτηθεί σε μεγάλο βαθμό με εικόνες ασθενών λευκών ανθρώπων, τότε θα δυσκολευθεί πολύ, όχι μόνο να εντοπίσει άτομα με άλλο χρώμα δέρματος, αλλά και να καταλάβει ότι μπορούν να αρρωστήσουν και αυτοί.

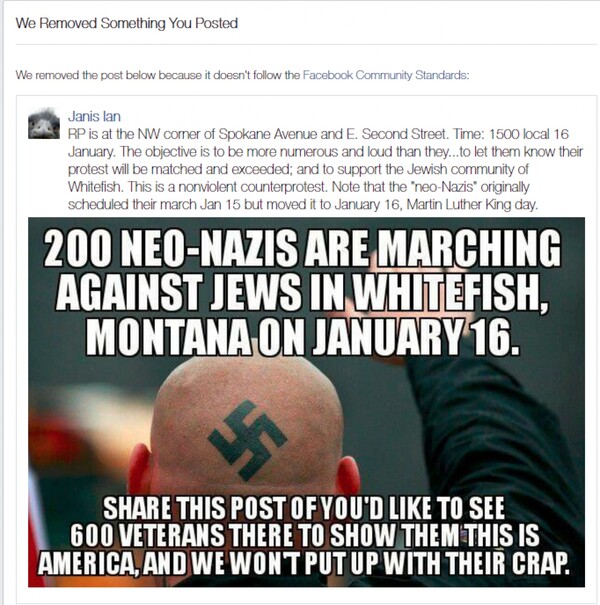

Η σημερινή Τεχνητή Νοημοσύνη του Facebook μπορεί να ανιχνεύσει μια σβάστικα σε κάποια φωτογραφία, αλλά δεν μπορεί ακόμη, να καθορίσει τον τρόπο με τον οποίο χρησιμοποιείται το σύμβολο. Μετά τα γεγονότα στο Σάρλοτσβιλ, το Facebook εξέφρασε δημόσια συγνώμη για την κατάργηση ενός post που περιελάμβανε μια σβάστικα, αλλά συνοδευόταν από ένα κείμενο, που ουσιαστικά έκανε έκκληση να σταματήσει η εξάπλωση του μίσους. Αυτό είναι μόνο ένα μικρό παράδειγμα της αποτυχίας των αλγόριθμων του Facebook, όπως και ο χαρακτηρισμός ως «σεξουαλικό περιεχόμενο» και η πρόσφατη κατάργηση φωτογραφίας με το γυμνό άγαλμα του Ποσειδώνα στην Μπολόνια. Με τον ίδιο τρόπο ο αλγόριθμος ενδέχεται να μπλοκάρει κάθε είδους φωτορεπορτάζ ή άλλης είδησης λόγω χρήσης πιθανών συμβόλων του μίσους.

Οι ιστορικές φωτογραφίες που μοιράζονται για εκπαιδευτικούς σκοπούς είναι ένα ακόμη παράδειγμα - το 2016, το Facebook προκάλεσε μια αξέχαστη διαμάχη μετά την απομάκρυνση της ιστορικής φωτογραφίας "napalm girl" του Nick Ut. Η φωτογραφία του 1972 που απεικονίζει ένα γυμνό κορίτσι να τρέχει μετά την έκρηξη μιας βόμβας ναπάλμ στο Βιετνάμ ανέβηκε αρχικά στην πλατφόρμα από τον Νορβηγό συγγραφέα Tom Egelad. Το Facebook την κατέβασε και μπλόκαρε τον Egelad. Όταν η νορβηγική εφημερίδα Aftenposten πήρε την ιστορία και την μοιράστηκε στο Facebook (μαζί με την αντίστοιχη εικόνα) έλαβε πίσω με την ίδια απάντηση: «Οποιαδήποτε φωτογραφία ανθρώπων που εμφανίζουν πλήρως γυμνά γεννητικά όργανα ή γλουτούς, ή πλήρως γυμνό θηλυκό στήθος, θα αφαιρείται». Η διαγραφή της φωτογραφίας από πολλές σελίδες χρηστών προκάλεσε τόσο έντονες αντιδράσεις και πρωτοσέλιδα στη Νορβηγία, που αργότερα το κοινωνικό δίκτυο αναγκάστηκε να αποκαταστήσει τη φωτογραφία απ' όπου είχε αφαιρεθεί.

Όλα δείχνουν ότι η ΤΝ μπορεί άνετα να χρησιμεύσει ως αρχικός έλεγχος, αλλά χωρίς τον ανθρώπινο παράγοντα είναι ένα αποτυχημένο σύστημα. Χωρίς συντονιστές που διαπιστώνουν εάν όντως κάποιο περιεχόμενο παραβιάζει τα κοινοτικά πρότυπα, η ΤΝ δεν μπορεί να λειτουργήσει. Παρά τις συνεχείς βελτιώσεις της, αυτό δεν μπορεί να αλλάξει στο άμεσο μέλλον. Και αυτό το γνωρίζουν πολύ καλά τα μεγάλα δίκτυα. Ίσως, γι' αυτό το Facebook αποφάσισε ότι θα αυξήσει το ανθρώπινο δυναμικό της ομάδας ελέγχου του κατά 20.000 και το YouTube κατά 10.000.

Μόνο με περισσότερο ανθρώπινο μυαλό στον έλεγχο, η εξυπνάδα των μηχανών μπορεί να καταφέρει να γίνει πιο αποτελεσματική. Έχει αποδείξει έμπρακτα, άλλωστε, ότι μπορεί κάτι να κάνει. Έστω και εάν απαιτεί αναθεωρήσεις από ανθρώπινο δυναμικό. Μπορεί να αναγνωρίζει τις τάσεις αυτοκτονίας σε κάποια ανάρτηση (εάν διαβάσει γρήγορα και απολεσματικά λέξεις κλειδιά που οδηγούν σε αυτό το συμπέρασμα) πιο γρήγορα από τον άνθρωπο, αλλά σίγουρα δεν μπορεί να «κρίνει» εάν η ανάρτηση είναι αληθινή, υποθετική ή απλά περιέχει ένα στίχο από ένα ποίημα.

H τεχνολογία της ΤΝ έχει κάνει τεράστια πρόοδο, αλλά έχει έναν πολύ μεγάλο δρόμο μπροστά της. Βασικά, λειτουργεί καλύτερα για να διευκολύνει τους ανθρώπους συντονιστές, τους βοηθά να εργάζονται γρηγορότερα και σε μεγαλύτερη κλίμακα. Αλλά, για την ώρα, δεν μπορεί να σταθεί στα πόδια της 100% αυτοματοποιημένη, σε καμία πλατφόρμα.

Βέβαια, στην εποχή που ζούμε, η τεχνολογία έχει αποδείξει ότι εξελίσσεται με ταχύτατους ρυθμούς, που κανένας νόμος και καμία δεοντολογία δεν μπορούν να συμβαδίσουν μαζί τους. Και η συντήρηση των κοινωνικών μέσων δεν αποτελεί εξαίρεση στον κανόνα. Για την ώρα, αυτό το κομμάτι της τεχνολογικής ανάπτυξης θα μπορούσε να σημαίνει αυξημένη ζήτηση σε εργαζόμενους, εκπαιδευμένους στις ανθρωπιστικές επιστήμες ή την ηθική, κάτι που οι περισσότεροι προγραμματιστές, σίγουρα, δεν κατέχουν. Γιατί, όσο ο ρυθμός, η ταχύτητα και η εξέλιξη δεν σταματούν, άλλο τόσο θα πρέπει και οι χρήστες ενός νοήμονος συστήματος να διασφαλίζουν ότι η ηθική συνιστώσα του δεν θα μείνει ποτέ πίσω από όλη αυτήν την τεχνολογία αιχμής.

σχόλια